Instituto Informa prepara mini curso para profissionais de comunicação que desejam trabalhar com a Inteligência Artificial Generativa (IAG)

Produção de textos, fotos, vídeos e tudo mais que você imaginar. Desde que o mundo foi apresentado à Inteligência Artificial Generativa (IAG) no fim de 2022, mais precisamente no formato do chatbot GPT (OpenIA), temos visto uma corrida das techs, com a apresentação de novos modelos como o Gemini (Google) e o Copilot (Microsoft). Mas você sabe como utilizar de forma mais eficiente essas ferramentas?

No Instituto Informa, estamos elaborando um curso de capacitação de gestores, profissionais de comunicação (equipes de campanhas eleitorais, jornalistas e a área do marketing), entre outros, que, eventualmente, precisam utilizar IA. A ideia é explicar como os Grandes Modelos de Linguagem (LLM, sigla em inglês), que estão por trás dessa geração de chatbots, funcionam, e como podemos adotar algumas estratégias para evitar erros e tirar o máximo de proveito dessas ferramentas.

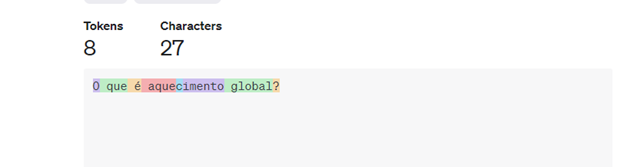

Aqui, apresento uma lista do que chamamos de boas práticas, ou seja, requisitos que você pode seguir desde já para obter os melhores resultados dos chatbots. Antes, uma explicação rápida. O modelo LLM trabalha com o que chamamos de tokenização dos textos. Ou seja, se escrevo para o chatbot “o que é aquecimento global?”, o modelo vai quebrar a minha frase em pequenos segmentos. A partir do conjunto de dados textuais com os quais ele foi treinado, o chatbot “compreende” a sequência de palavras, e passa a prever estatisticamente a sequência da resposta. Note que o chatbot não compreende o sentido da frase como nós humanos fazemos. Ele apenas estima estatisticamente, e com grande precisão, o conjunto de texto, aqui transformado em tokens.

Veja este exemplo. O GPT quebrou a minha frase em oito tokens, com 27 caracteres, e é assim que ele “decodifica” a frase, calcula a correlação entre elas, e busca uma resposta também com tokens correlacionados.

Bem, parece mais claro agora que, se o LLM trabalha com estatística e não semântica, o melhor é produzirmos Prompts (o texto que escrevemos com a solicitação para o chatbot) que potencialize a previsão dos tokens, ou seja, que torne mais precisa as respostas que a ferramenta produz.

No curso, vamos detalhar melhor essas estratégias, mas, por enquanto, podemos listar as seguintes dicas, ou seja, boas práticas para você produzir prompts mais eficientes. Essas dicas são defendidas por engenheiros que trabalham na criação de chatbots em empresas como a Microsoft, OpenIA e Google.

Especifique o contexto. O contexto é importante, quanto mais você especificar, como domínio, tópico, etc., melhor para o trabalho do chatbot.

Limite a saída. Se você deseja um número específico de itens ou um comprimento específico, especifique. Diga claramente para o chatbot: “faça dois exemplos de cards para veicular no Instagram”

Especifique o que e como. Lembre-se de mencionar o que deseja e como deseja, por exemplo: “faça dois exemplos de cards para veicular no Instagram, com o conteúdo que expresse o tema principal da nossa campanha focada na importância do bem-estar da população. Meu público de interesse são eleitores brasileiros de 16 a 24 anos, moradores do Nordeste, e o texto deve enfatizar a sua relação a promoção de políticas públicas”

Use modelos. Você pode desejar enriquecer seus prompts com dados de sua empresa. Claro que você não vai incluir dados reais, mas é possível trabalhar com modelos. Por exemplo, para o caso de dois cards para uma campanha focada no tema do bem-estar, você pode criar tópicos de um modelo hipotético que você considera essencial. O chatbot trabalha melhor quando apresentamos modelos.

Soletre corretamente. Os LLMs podem fornecer respostas corretas, mas para isso é preciso apresentarmos prompts escritos com precisão, com texto claro, simples e direto. Isso ajuda e muito o modelo a produzir melhores respostas.

Deixe um comentário.